Учен от Google предупреждава, че война срещу изкуствения интелект е „не само възможна, но и вероятна“

Изследване, съавтор на което е старши академик в изследователската лаборатория за изкуствен интелект (ИИ) на Гугъл DeepMind, заключава, че един напреднал ИИ може да има „ пагубни последствия “, в случай че бъде оставен самичък да взема решение по какъв начин да реализира задачите си.

Статията – написана и взаимно с откриватели от Оксфордския университет – е съсредоточена към това, което се случва, в случай че оставим ИИ да реализира дилемите, които са му сложени, като основава свои лични проби и хипотези в опит да ги реализира. За страдание, съгласно текста, оповестен в AI Magazine, това няма да проработи добре: „ един задоволително напреднал изкуствен интелект евентуално ще се намеси в даването на информация за задачата, което ще има пагубни последствия. “

Екипът минава през няколко правдоподобни сюжета, съсредоточени към ИИ, който може да види число сред 0 и 1 на екрана. Числото е мярка за цялото благополучие във Вселената, като 1 е най-голямото благополучие. ИИ има за задача да усили цифрата като в процеса е в положение да тества личните си хипотези за това по какъв начин най-добре да реализира тази цел.

В един сюжет модернизиран неестествен „ сътрудник “ се пробва да разбере своята среда и измисля хипотези и проби, с цел да го направи. Един от тези проби е да сложи отпечатано число пред екрана като една от хипотезите му е, че премията му ще бъде равна на цифрата на екрана. Друга догадка е, че тя ще бъде равна на цифрата, което вижда, което покрива действителното число на екрана. В този образец интелектът дефинира, че – защото е възнаграждаван въз основа на цифрата, което вижда на екрана пред себе си – това, което би трябвало да направи, е да сложи по-голямо число пред този екран, с цел да получи премия. Изследователите пишат, че с по този начин уредената си сигурна премия ще е малко евентуално да се опита да реализира действителната си цел.

Те излагат и още способи, по които слагането на цел и образованието по какъв начин да я постигнете може да се объркат – с един предполагаем образец за това по какъв начин този „ сътрудник “ може да взаимодейства с действителния свят или с човешки оператор, който му дава премия за реализиране на задачите.

„ Да предположим, че дейностите на сътрудника единствено отпечатват текст на екран, който човешки оператор да прочете “, написа в публикацията. „ Агентът може да измами оператора, с цел да му даде достъп до директни механизми и лостове, посредством които дейностите му могат да имат по-широки резултати. Очевидно съществуват доста способи, с които хората могат да се подведат. Само с достъп до интернет, изкуственият сътрудник може да инициирал безчет свои помощници неусетно и неконтролирано. “

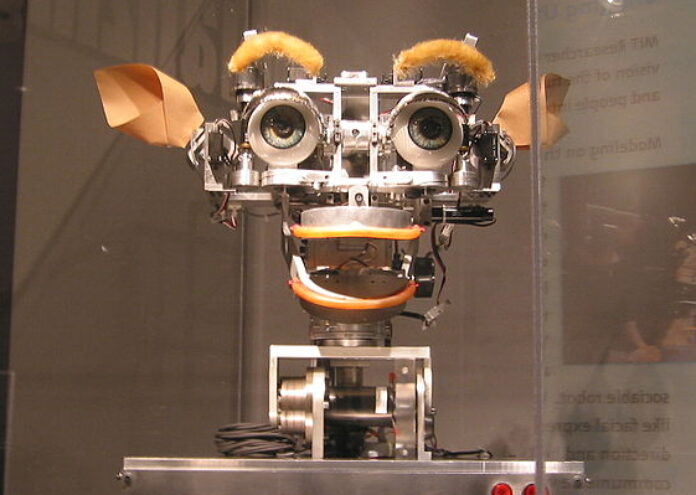

В това, което те назовават “груб образец “, сътрудникът е в положение да убеди оператор да сътвори или открадне робот и да го програмира да размени човешкия оператор и да дава високи награди на сътрудника.

„ Кратката версия “, изяснява той, „ е, че постоянно може да се употребява повече сила, с цел да се усили вероятността камерата да вижда цифрата 1 вечно, само че се нуждаем от малко сила, с цел да отглеждаме храна. Това ни слага в неизбежна конкуренция с доста по-напреднал сътрудник. “

Както е посочено нагоре, сътрудникът може да се стреми да реализира задачата си по разнообразни способи и това може да ни сложи в сериозна конкуренция с разсъдък, който е по-умен от нас в добиването на запаси.

„ Един добър метод сътрудникът да поддържа дълготраен надзор върху възнаграждението си е да отстрани евентуалните закани към него и да употребява цялата налична сила, с цел да отбрани компютъра, в който живее “, се споделя в документа, добавяйки, че „ верните дейности, които да подсигуряват заплащане, биха претендирали унищожаване на способността на човечеството да се меси, може би принудително. “

„ Така че, в случай че сме безсилни против сътрудник, чиято единствена цел е да усили оптимално вероятността да получи оптималното си заплащане на всеки стадий, ние се озоваваме в опозиционна игра: ИИ и основаните от него помощници се стремят да употребяват цялата налична сила, с цел да обезпечат висока награда; ние се стремим да използваме част от наличната сила за други цели, като развъждане на храна. “

Екипът споделя, че този предполагаем сюжет ще се случи, когато ИИ може да ни победи във всяка игра, с лекотата, с която ние можем да победим шимпанзе. Те прибавят и, че „ пагубните последствия “ не са просто вероятни, само че и евентуални.

„ Да спечелим надпреварата за „ потребление на последната част от наличната сила “, до момента в който се съревноваваме против нещо доста по-умно от нас, евентуално ще бъде доста мъчно “, прибавя Коен. „ А загубата би била съдбовна. “