Google се похвали с най-бързия AI ускорител

Новата система се базира на тензорни копроцесори TPU версия 4

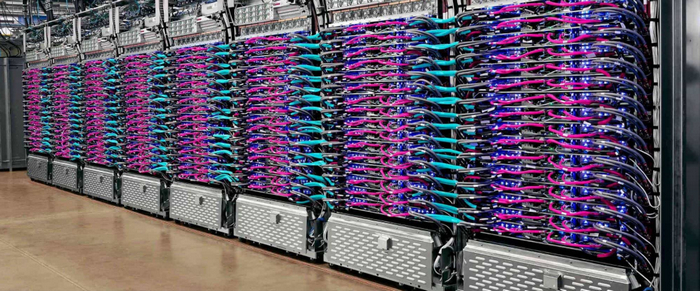

Новата тестова платформа на Гугъл TPU съдържа 4096 копроцесора за изкуствен интелект

(снимка: Google)

Гугъл създава лични ускорители за машинно образование от дълго време – още през 2017 година се появи модулът TPU, кадърен бързо да умножава матрици 256×256. Третата версия на TPU сложи редица върхове в региона на образованието на невронни мрежи, а в този момент интернет компанията показва TPU v4 като най-бързия ускорител за изкуствен интелект.

Не всеки ще се съгласи с тази дефиниция, защото оповестените резултати от теста ML Perf 0.7 могат да се поясняват малко по-различно. Така да вземем за пример, Nvidia твърди, че най-бърз от предлаганите на пазара е суперкомпютърът, основан на нейния ускорител A100, до момента в който Гугъл употребява в тестванията към момента необявен публично ускорител TPU v4.

Системите за изкуствен интелект стъпват или на към този момент подготвени невронни мрежи, или на такива в развой на образование. Във втория случай са нужни в порядък повече изчислителни запаси, което допуска потребление на мощни многоядрени системи. За оценка на продуктивността на системите постоянно се употребява набора от проби MLPerf.

В основата на системата-рекордьор TPU v3 на Гугъл стояха модули Cloud TPU Pod, като всеки от тях съдържаше повече от 1000 чипа Гугъл TPU и доближаваше продуктивност от над 100 Pflops. Основният съперник Nvidia също обръща доста съществено внимание на AI ускорителите. Дори основаните на V100 решения елементарно се конкурираха с TPU v3, а най-новият A100, основан на архитектура Ampere, показва още по-високи равнища на продуктивност в теста MLPerf Training.

Гугъл Research обаче разгласява резултати от нов тест с MLPerf Training 0.7, който се базира на към момента идните да излязат тензорни копроцесори TPU v4. Съперничеството с A100 е много забавно – при някои сюжети Nvidia се оказва по-бърза, само че в други технологията на Гугъл има превес.

Nvidia, от своя страна, регистрира 16 върха с новия си ускорител DGX A100 и акцентира, че нейните артикули към този момент се налични за покупки (и извършват всевъзможни ML Perf проби или действителни натоварвания), до момента в който резултатите на съперниците постоянно са или непълни или получени на хардуер, който е пробен или не може да се придобие сега.

При тестванията на Гугъл са употребявани реализации на AI модели в TensorFlow, JAX, PyTorch, XLA и Lingvo. Четири от осемте модела са „ подготвени ” за по-малко от 30 секунди, което е доста впечатляващ резултат. За съпоставяне, през 2015 година на актуалния по това време хардуер сходен развой на образование би лишил повече от три седмици. Като цяло, TPU v4 дава обещание да е 2,7 пъти по-бърз от TPU v3.

Подробна информация за тестванията с MLPerf 0.7 е оповестена в формалния блог на Гугъл Cloud, наред с детайлности за основани на TPU системи, само че към момента лимитирани до третата версия на чипа. Засега е известно, че четвъртото потомство TPU е повече от два пъти по-бързо в интервенциите за умножение на матрица, има по-бърза подсистема на паметта и усъвършенствана система за взаимосвързване.

Новата тестова платформа на Гугъл TPU съдържа 4096 копроцесора за изкуствен интелект

(снимка: Google)

Гугъл създава лични ускорители за машинно образование от дълго време – още през 2017 година се появи модулът TPU, кадърен бързо да умножава матрици 256×256. Третата версия на TPU сложи редица върхове в региона на образованието на невронни мрежи, а в този момент интернет компанията показва TPU v4 като най-бързия ускорител за изкуствен интелект.

Не всеки ще се съгласи с тази дефиниция, защото оповестените резултати от теста ML Perf 0.7 могат да се поясняват малко по-различно. Така да вземем за пример, Nvidia твърди, че най-бърз от предлаганите на пазара е суперкомпютърът, основан на нейния ускорител A100, до момента в който Гугъл употребява в тестванията към момента необявен публично ускорител TPU v4.

Системите за изкуствен интелект стъпват или на към този момент подготвени невронни мрежи, или на такива в развой на образование. Във втория случай са нужни в порядък повече изчислителни запаси, което допуска потребление на мощни многоядрени системи. За оценка на продуктивността на системите постоянно се употребява набора от проби MLPerf.

В основата на системата-рекордьор TPU v3 на Гугъл стояха модули Cloud TPU Pod, като всеки от тях съдържаше повече от 1000 чипа Гугъл TPU и доближаваше продуктивност от над 100 Pflops. Основният съперник Nvidia също обръща доста съществено внимание на AI ускорителите. Дори основаните на V100 решения елементарно се конкурираха с TPU v3, а най-новият A100, основан на архитектура Ampere, показва още по-високи равнища на продуктивност в теста MLPerf Training.

Гугъл Research обаче разгласява резултати от нов тест с MLPerf Training 0.7, който се базира на към момента идните да излязат тензорни копроцесори TPU v4. Съперничеството с A100 е много забавно – при някои сюжети Nvidia се оказва по-бърза, само че в други технологията на Гугъл има превес.

Nvidia, от своя страна, регистрира 16 върха с новия си ускорител DGX A100 и акцентира, че нейните артикули към този момент се налични за покупки (и извършват всевъзможни ML Perf проби или действителни натоварвания), до момента в който резултатите на съперниците постоянно са или непълни или получени на хардуер, който е пробен или не може да се придобие сега.

При тестванията на Гугъл са употребявани реализации на AI модели в TensorFlow, JAX, PyTorch, XLA и Lingvo. Четири от осемте модела са „ подготвени ” за по-малко от 30 секунди, което е доста впечатляващ резултат. За съпоставяне, през 2015 година на актуалния по това време хардуер сходен развой на образование би лишил повече от три седмици. Като цяло, TPU v4 дава обещание да е 2,7 пъти по-бърз от TPU v3.

Подробна информация за тестванията с MLPerf 0.7 е оповестена в формалния блог на Гугъл Cloud, наред с детайлности за основани на TPU системи, само че към момента лимитирани до третата версия на чипа. Засега е известно, че четвъртото потомство TPU е повече от два пъти по-бързо в интервенциите за умножение на матрица, има по-бърза подсистема на паметта и усъвършенствана система за взаимосвързване.

Източник: technews.bg

КОМЕНТАРИ